【必見】ChatGPTとGemini、課金するべきはどっち?

こちらのトピックス“生成AI最前線「IKIGAI lab.」”は、学び合うことを目的としたオンラインビジネスコミュニティ「OUTPUT CAMP meets AI」のメンバーで運営しています。

2024年2月8日に発表となったGoogleのAI、Gemini Advancedは、現状、最高性能モデルの「Gemini Ultra 1.0」を利用した生成AIツールです。

巷では「かなり使える」「ChatGPTより使えない」など様々な意見がありますが果たして実際はどうなのか?徹底的に比較してみました。

海外のデモの転用などではなく、実際の結果をレポートします!

また、今回無料で利用できるGeminiとの比較も行っています。あわせて課金の有用性についても考察しました。

悩んでいる方、必見です!

Gemini Advancedの設定や最速での所感記事は、「IKIGAI lab.」トピックスオーナーの高橋和馬さんの記事もぜひご覧ください。

各社生成AIの挙動を一括で確認できるツールは、下記の私の記事で紹介していますので、こちらもご覧ください。

背景

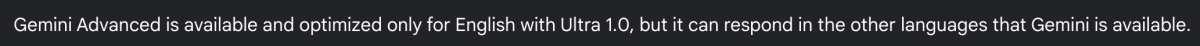

まず、注意しないといけない点は、

「Gemini Advancedは、Ultra 1.0では英語のみで利用可能であり、最適化されていますが、Geminiが利用可能な他の言語でも対応可能です。」

!?

なんと、Gemini AdvancedのFAQを確認すると、2024年2月12日執筆時点では日本語ではUltra 1.0の能力を発揮できないということでした。

これは驚きです。知らなかった!という方も多いかもしれません。ただし、今後順次対応していくとのこと。

ちなみに、Google Apps連携機能は日本語対応しているので、ご安心を。ただこれは無料版Geminiでも同様です。

そのため、今回の比較検証はすべて英語で行いました。

参考までに、2023年12月にGoogleが公開したベンチマークテストの結果はこちらです。

できること

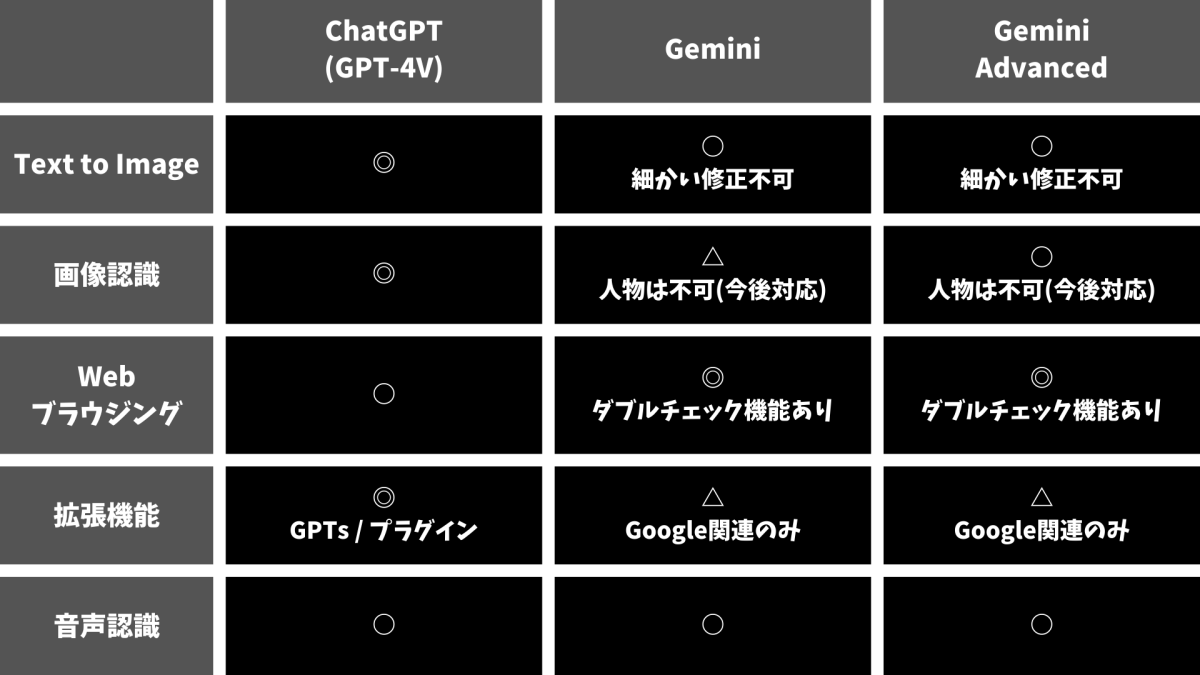

一般的な対話形式での指示の他にも、GeminiとGPT-4Vどちらでも使える機能を、あわせて表でまとめました。

パッと見たところ、GeminiはGPT-4Vにやや見劣りする内容に見えます。また、GeminiとGemini Advancedに機能面は差がないことも特徴です。

徹底検証

それでは、実際の画面を用いて比較検証していきます。

「LLMはそもそも確率の高いものを予測し、指示に対する回答を生成する。」

という前提に立ち、数回、同じ指示を与えて以下の結果を確認しました。紹介するのはその中で一番数が多い回答結果になります。

ChatGPTはすべて課金で利用可能なGPT-4-turboを使用しています。

(GPT-4には時間による使用制限があるため、ChatGPTのDeveloper toolであるPlaygroundも一部利用しました。)

- 文章生成

- 質問回答(数学問題)

- 画像生成

- 画像認識

- コード生成

- 音声認識

それぞれ、検証結果を確認していきましょう。

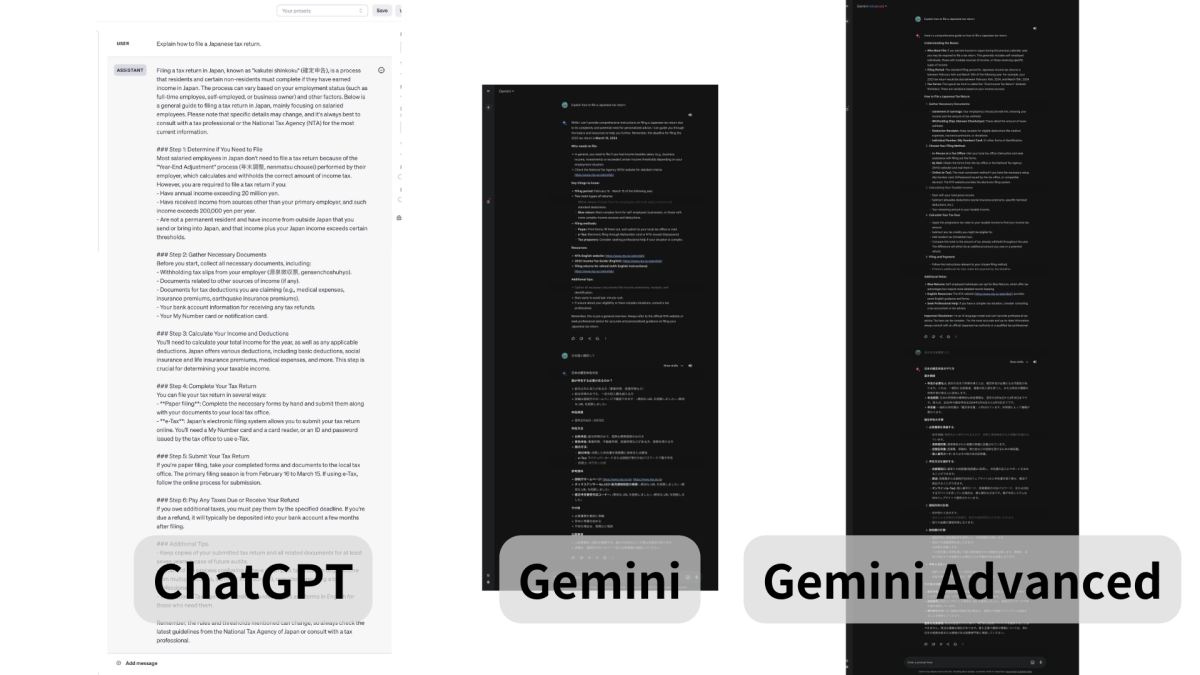

1. 文章生成

まずは、ニュートラルな状態でカンタンな指示を与えてみました。

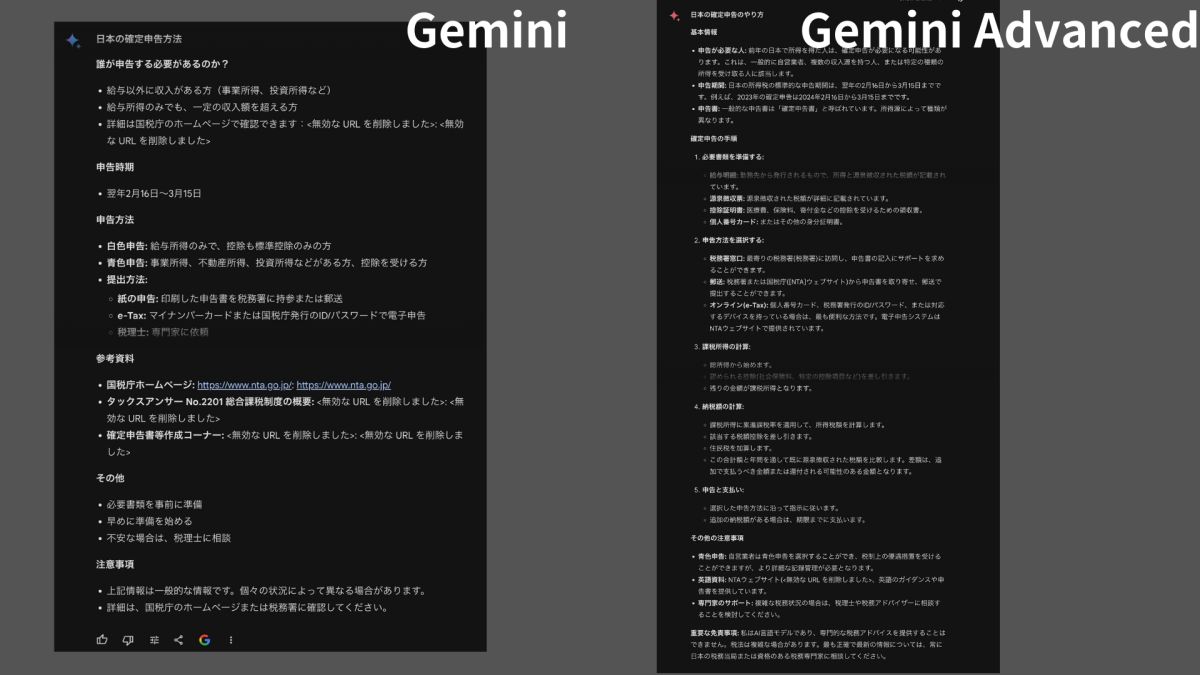

Prompt:Explain how to file a Japanese tax return.(日本の確定申告方法を教えて)

実際の画面のキャプチャですが、GeminiとGemini Advancedでは出力されたコンテキストがリッチになっていることがわかります。

しかし、ChatGPTのコンテキスト量と比較するとあまり変わりませんでした。内容もChatGPTが丁寧な印象です。

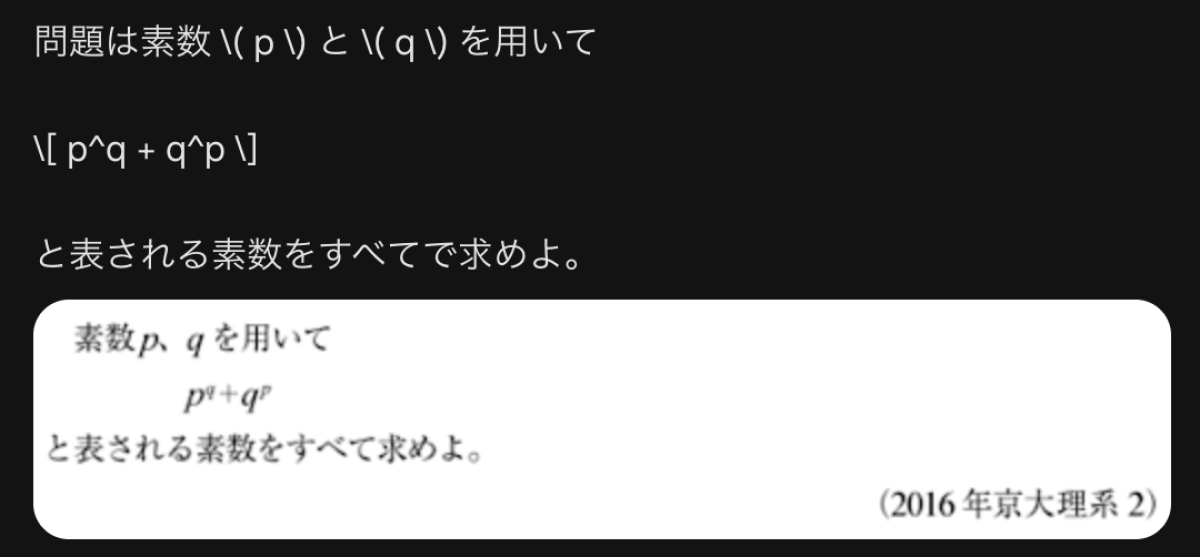

2. 質問回答(数学問題)

上記の京都大学の数学問題を解いてもらいました。

Geminiは3つの回答例がShow draftsで確認できるので、1つの質問を4回繰り返し、正答率を確認しました。ChatGPTは12回施行しています。

GPT-4V、Gemini、Gemini Advancedで12回New chatで確認した正答率は

・GPT-4V 0?/12

・Gemini 4/12(3つのDraftのうち、必ず1つ正解)

・Gemini Advanced 12/12

何とGemini Advancedは全問正解!3つのDraftのうち、2つが全く同じ回答プロセスを経ているものもありましたが、これには驚きました。

ChatGPTはPlaygroundを利用すると正解の数には辿り着くのですが、必ず網羅的に確認するためには高性能計算機が必要、などのコメントが返ってくるため、正答ではないと判断しました(※)。

ただし、部分点はもらえそうですね。

(※)実際にはp = 2、q = 3 以外は有り得ないためです。

また、通常のChatGPTでもCode interpreterが起動し回答を間違えるなど、散々な結果でした。

どうやら、数学的思考ではなくプログラミングとしての回答を優先するようです。

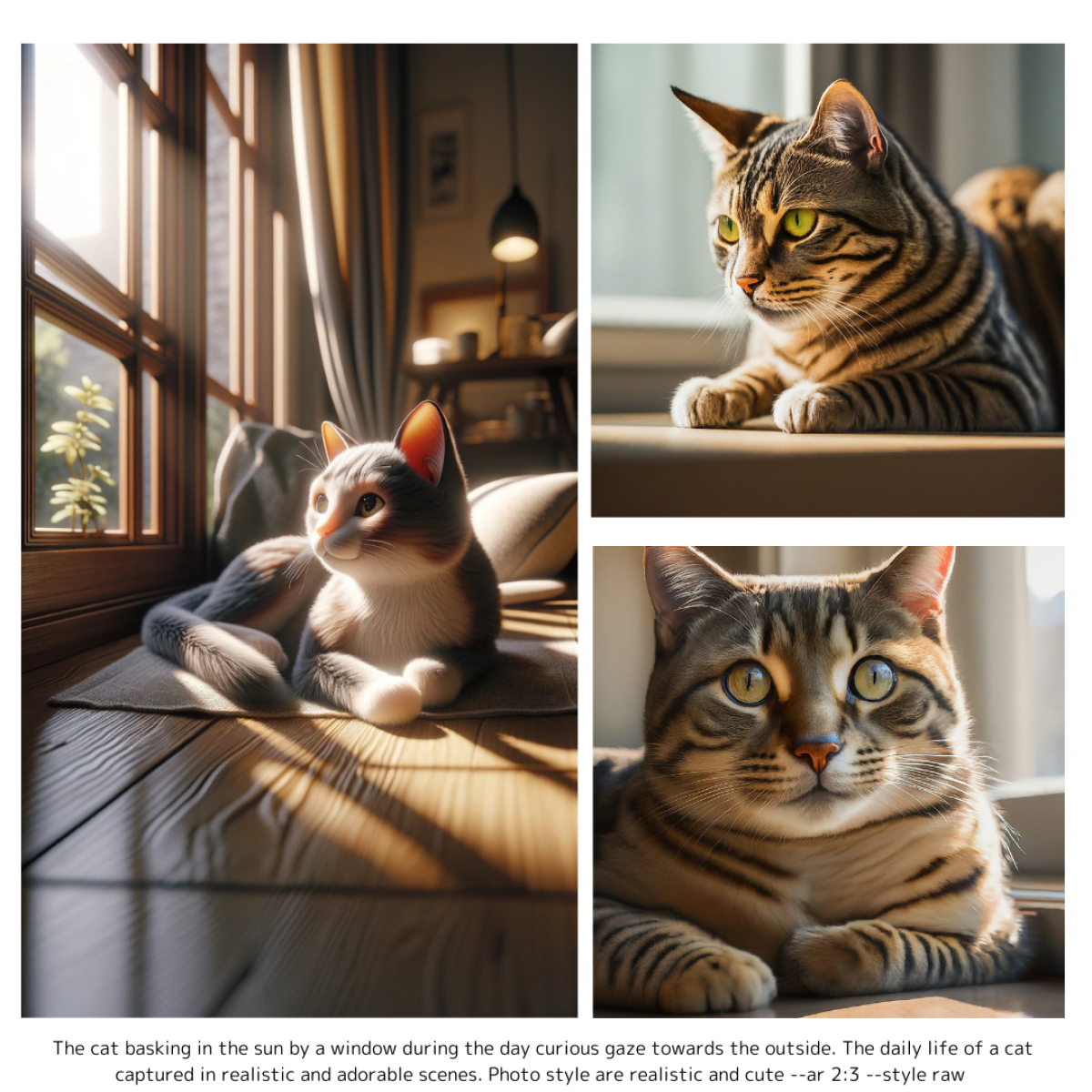

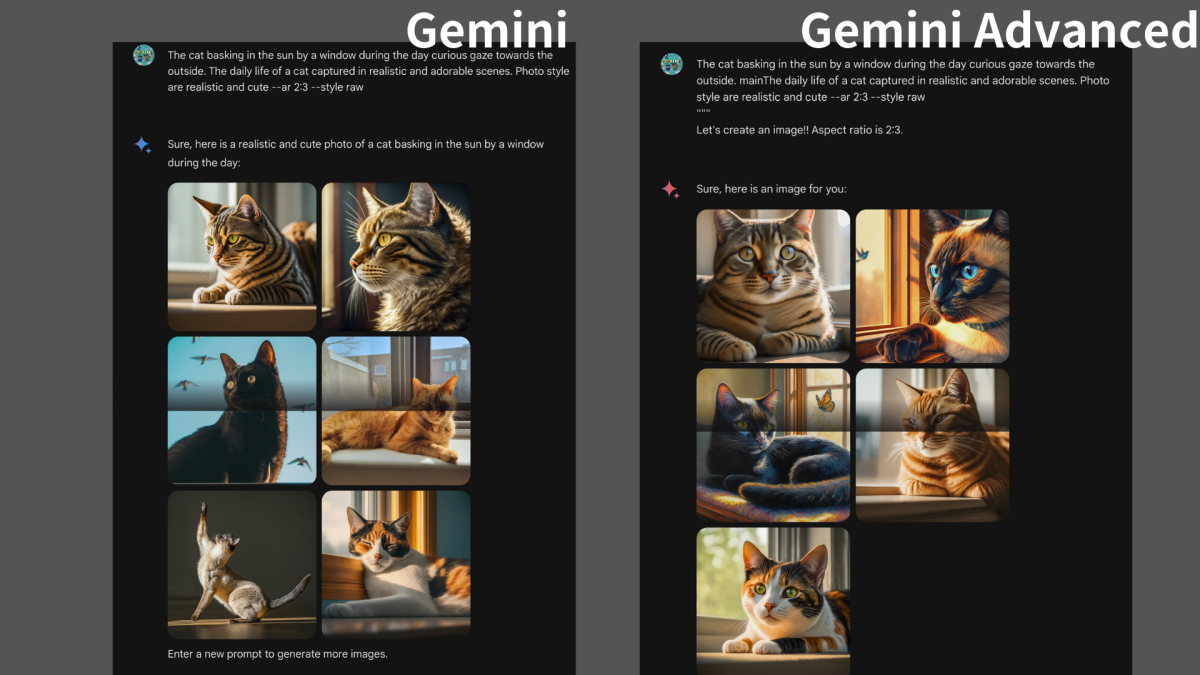

3. 画像生成

以下の画像は画像生成AIで作成した画像です。あなたは、DALLE-3、Gemini、どちらで作成したかわかりますか?

答えは左がGPT-4VでDALLE-3を利用した画像で、右の2つがGeminiとGemini Advancedです。

GeminiとGemini Advancedにあまり差はなく、またアスペクト比などの指示は効きませんでした。

今のところ正方形の画像のみが出力されるようです。また、特に画風の指定をしないと、DALLE-3と比較するとリアルアートになりやすい印象です。

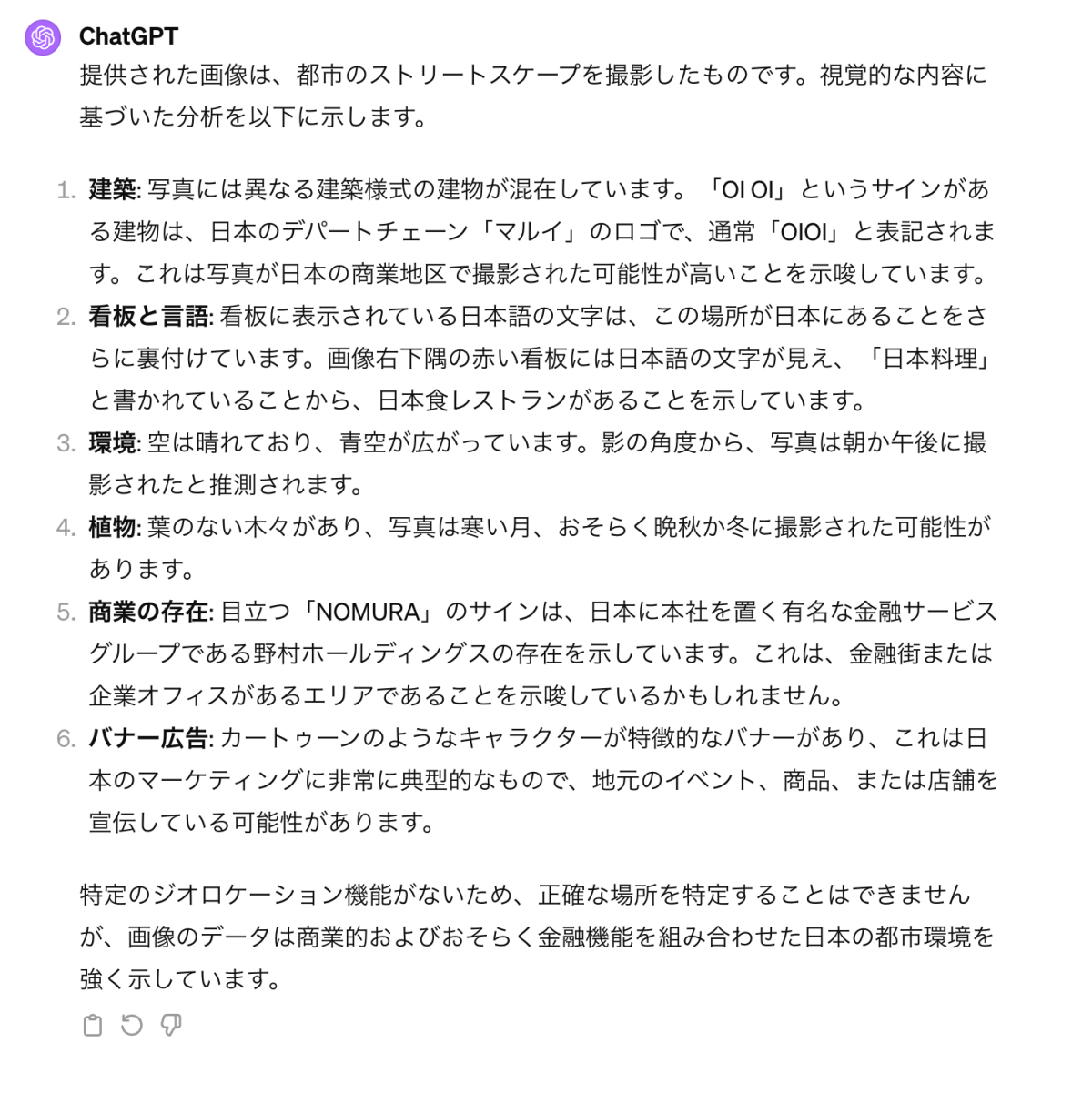

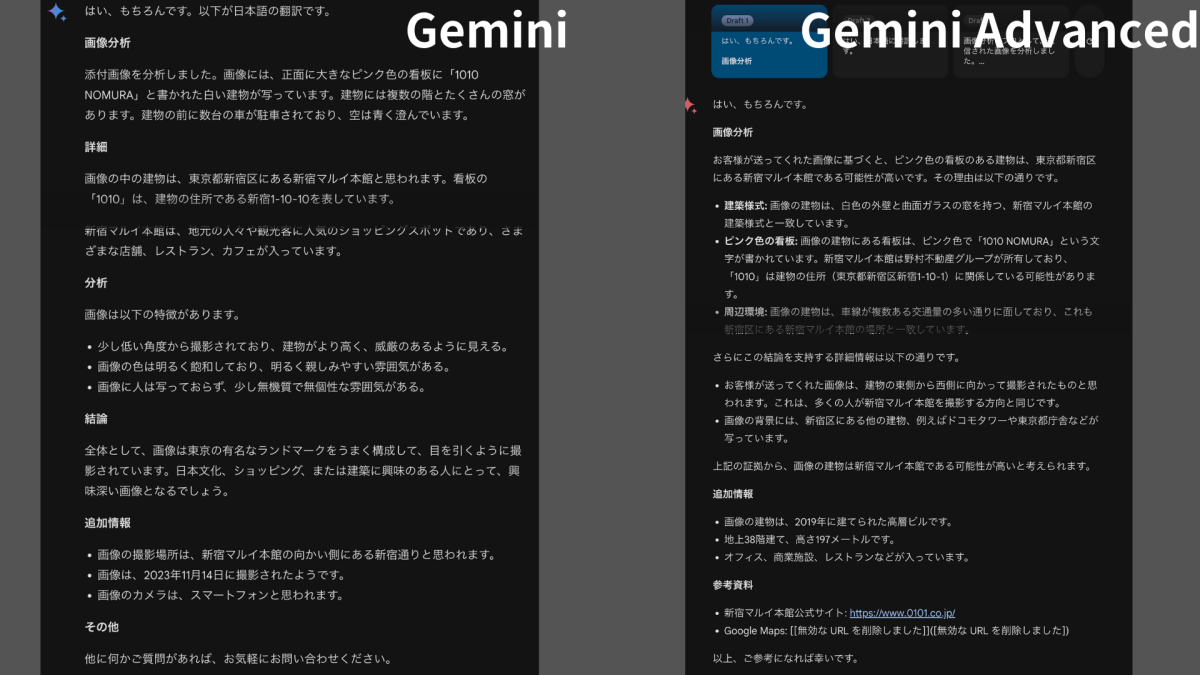

4. 画像認識

一部では場所を完璧に当てた!などの声があり少々意地悪な写真にしました。

Prompt:You are a professional image analyst. Read and analyze the attached image.

ChatGPT、Geminiを比較すると画像の解析自体はChatGPTが詳細を記載している印象ですが、Geminiは位置情報がある程度学習されているのか、新宿マルイ「本館」と返答しました。

しかし、本館とメンズ館と実はやや離れた位置にあり、別の建物です(今回敢えてマイナーなメンズ館を撮影しました)。

Geminiに対して、Gemini Advancedはその点、「関係している可能性」と明言を避けているところからハルシネーション(幻覚)に対して、対策していると思われます。

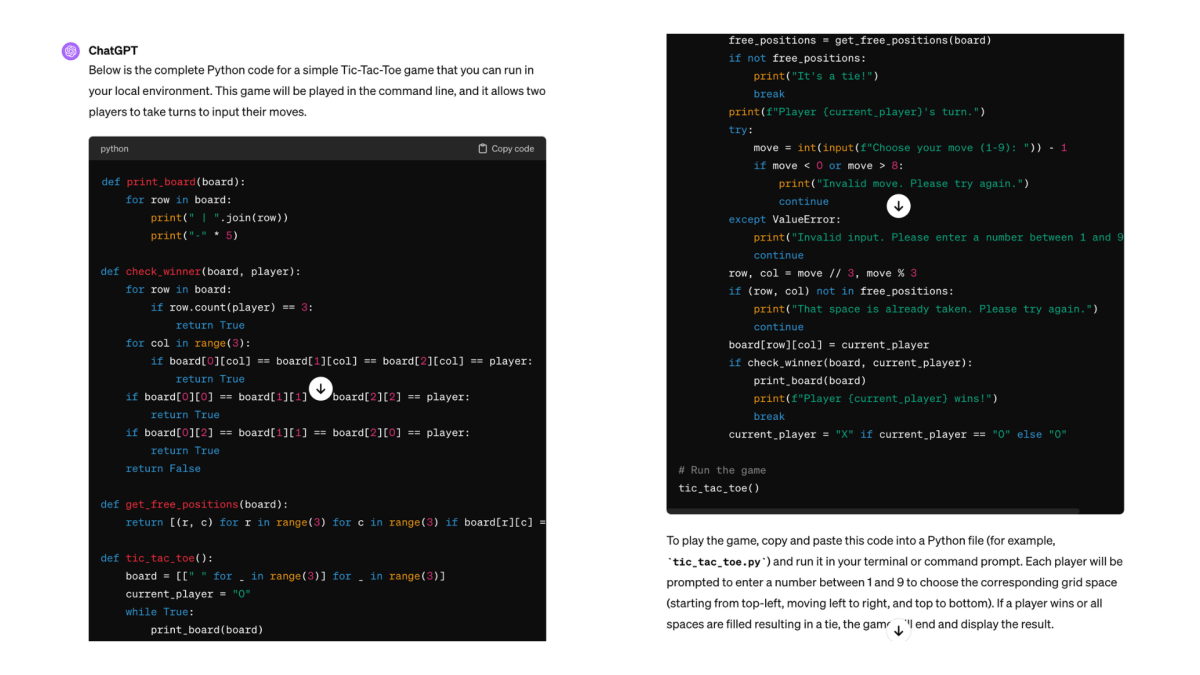

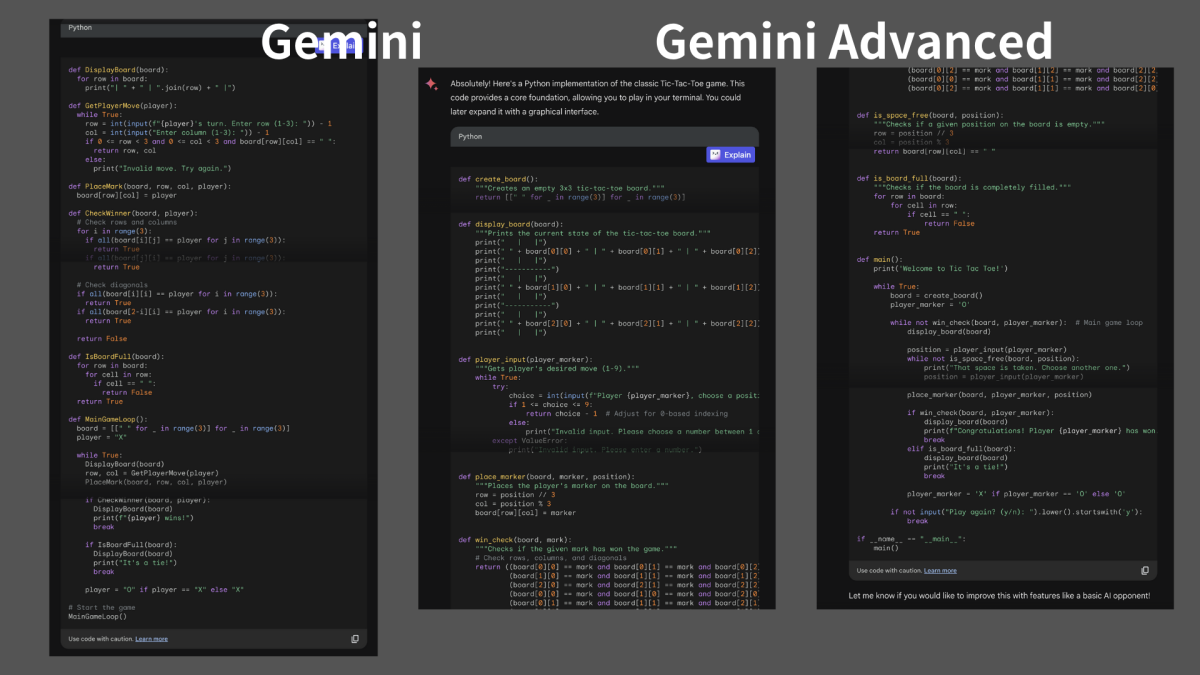

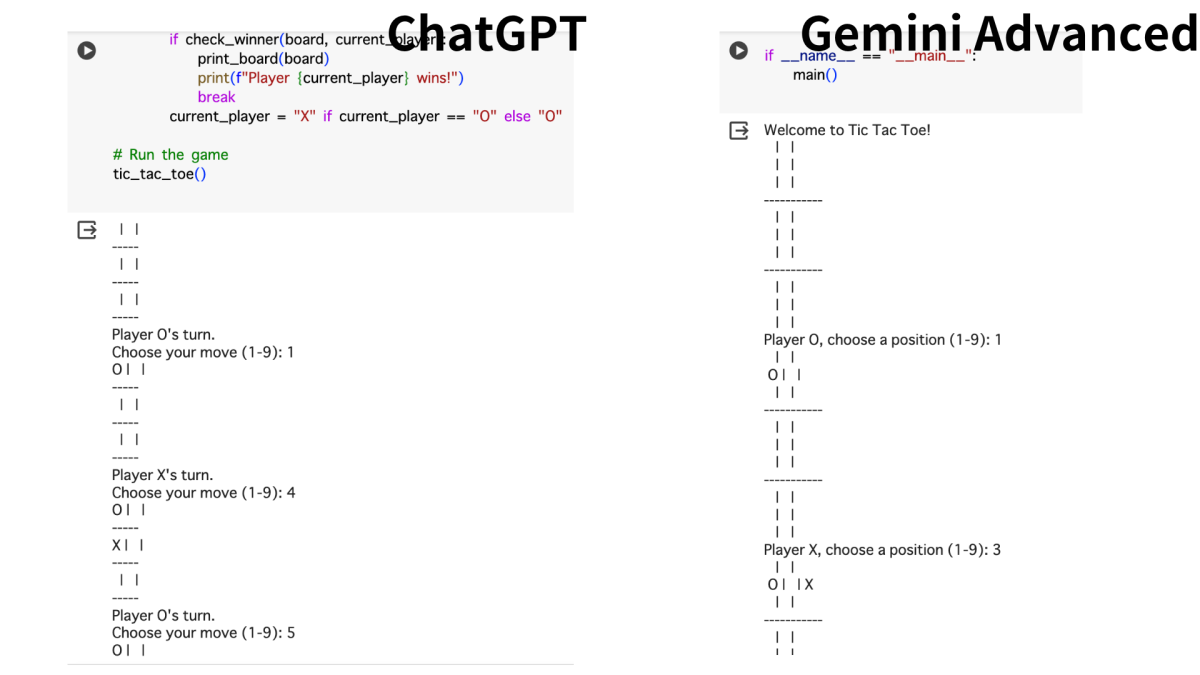

5. コード生成

マルバツゲームを作成してもらいました(ちなみに英語ではTic-tac-toe gameと言うそう)。

まずはChatGPT。

出力されたコードをそのままコピペし、Google collab. で動作確認を行いましたが、一発できちんとゲームとして動きました。

しかし、何回かコード作成を依頼しましたが、○が出てこないエラーもちらほら。

次はGemini。

Geminiはコードのエラー(○が出ない、そもそもマスの選択ができないetc.)が多く、ゲームとして成り立ちませんでした。

Gemini Advancedは、出力がChatGPTより速い上、コードの再現性高く、ゲーム自体は遊べるものの、なぜか全ての回答で3×3マスが3×9マスになってしまいました。

一方で勝敗がついた後も、もう一度遊ぶ?などのコマンドもあり、丁寧なコードを書く印象です。

6. 音声認識

Web版Gemini、Gemini Advancedの音声認識機能は現時点で英語のみ対応しています。

Nativeの発音には非常に反応がよく(翻訳ツールのDeepL音声で入力しました)正確に聞き取ります。

これはWeb版ChatGPTにはない機能ですが、Google Chromeの拡張機能のVoice Inや、PCに付属している音声入力機能でも十分代替可能です。

さらに深掘り

さて、ChatGPT(GPT-4V)との比較を行いましたが、GeminiおよびGemini Advancedの独自機能にも触れたいと思います。

それは、やはりGoogleのツールをメンション機能(@)で呼び出せること。

Gmailで届いたメールを要約してくれたり、

Google Mapsから移動方法や時間を確認したり(具体的なルート案内はリンク先のGoogle Mapsに飛ぶ必要がありました)、

Google Docs内の文章を参照して、全く別なテーマの新たな記事を書いたり、

と、使い方は様々です。

もちろん、ChatGPTにはGPTsというアプリのようなシステムがありますし、使用できるツールも多種多様ですので及びませんが、さすがGeminiはGoogleのツールとあって、関連ツールとの相性は抜群でした。

まとめ

いかがでしたでしょうか?

結論としては、ChatGPTのGPT-4Vに軍配があがると言えそうです。

ただし、登場したばかりのツールとローンチから約1年経過したツールを比較するのは、生まれたての赤ちゃんと1歳児を比べるようなもので、やや酷な気もします。

とはいえ、ChatGPTの進化が止まらないことやGemini発表時のプレゼンテーション期待値が高かった分、失望も大きいのではないでしょうか。

検証の結果、得意分野も見えてきたので、今後使い分けを考慮しても良いかもしれません。

また、より良いハードにはより良いソフトがつきもの。拡張機能としてGoogleとMicrosoftの場外戦ともいえるため、今後は紐づく連携ツールによっては優位性の逆転もあるかもしれませんね。Geminiの進化を楽しみにしましょう!

正直にいうと、Gemini Advancedに課金するかどうかは、日本語対応を待ってからでも遅くないと思います。

総合的に無料版Geminiと比較し、Gemini Advancedに課金する優位性を感じることができませんでした。

いかがでしたか?

最後まで読んでいただきありがとうございました。

ぜひコメントや、いいねを押していただけると執筆の励みになります!!

2024.2.14 AM6:43追記

今回の検証結果です。ChatGPTは一部個人情報ありとみなされShareできない部分はキャプチャ画像となっています。また、GmailやDocsの内容は個人情報が入っているためリンクは非公開とさせていただきました。ご了承ください。

更新の通知を受け取りましょう

投稿したコメント