【AI時代の教養】人間の知性と機械の知性はどう違うのか?

ChatGPTのような生成AIは、非常に正確性の高い回答をしてくれるようになりました。仮にアバターの中に生成AIがあると、瞬間的にはAIと気が付かない可能性もあります。ある機械が「人間的」かどうかを判定するためのテストであるチューリングテストを行ったら、実験の設定次第ですが、AIだと気が付かない可能性もあるでしょう。

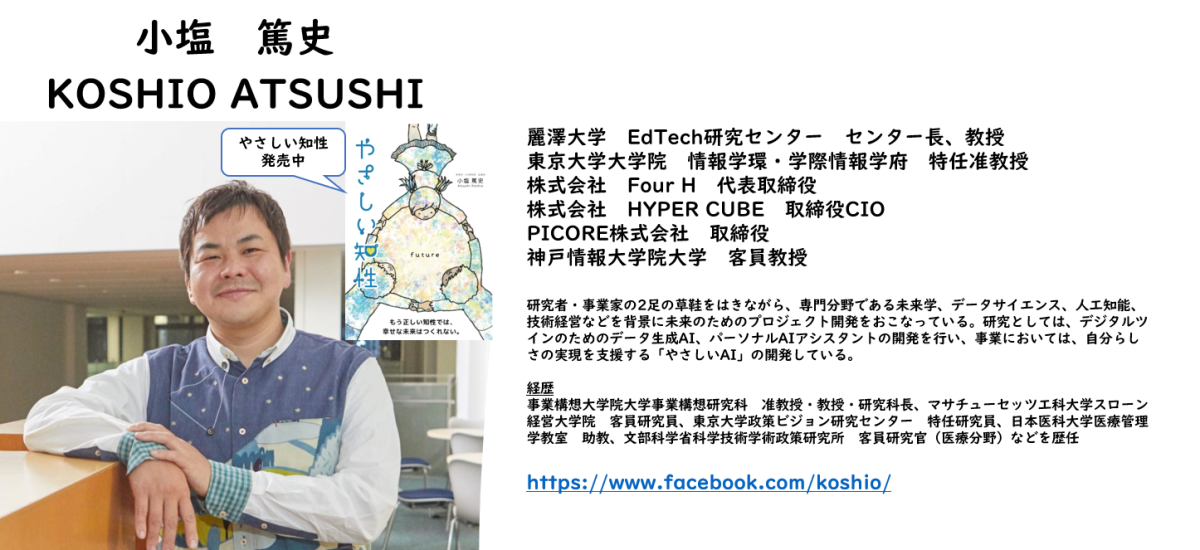

では、人間の知性と機械の知性はどう違うのでしょうか?違いについてはいろいろな解釈がありますが、拙著第7章の一節を一部改変してお伝えします。

**********************************

人間とAIの違い

人間とAIを比較する際、大きな違いは何でしょうか。

人間の知的活動には、認知、推論、理性、感性、そして決定という一連のプロセスが存在します。そして、このプロセスの最後に決定があるのが重要なポイントです。決定するから、われわれは行動することができます。

例えば、お腹が空いている状態で目の前の机にリンゴが置かれている場合、まずリンゴを認知し、次にそのリンゴが誰のものであるかを推論します。未知の人物のリンゴを食べた場合に何が起きるのかを理性的に推論する一方で、限界に近いほどの空腹感から食べたくなる感情が働きます。そして結局、感性に負けて、食べるという決定をし、手に取ってしまうこともあります。

人間の知的活動には、意志決定に先立って理性と感性が働いています。われわれは、常に理性的に判断するわけではなく、多くの場合、意志決定は感性、あるいはヒューリススティックと呼ばれる直感によって決まっています。

例えば、食事の場所を考えると時には以下のような選択が想定されます。

・理性的な選択

「少しお腹が空いているが、今日の移動ルートを考慮すると、レストランAで食事をする方がコストパフォーマンスが高いので、そこにしよう」

・感性的な選択

「少しお腹が空いていて、すぐ目の前に美味しそうなレストランBが目の前にあったので、入ろう」

もちろん、人それぞれですが、後者のような人も多いのではないでしょうか。人間は必ずしも理性的に意志決定を行っているわけではありません。

現在のAIが得意とするのは、理性的な意志決定のサポートです。ダイエットを助けるAIが存在すれば、そのAIは今晩の私に「お酒を飲むな」とアドバイスするでしょう。ダイエットを希望する私にとって、理性的なアドバイスは「お酒を飲まない」と「高タンパクで低糖質の食事をする」です。しかし、私はお酒が飲みたいし、炭水化物も食べたい。理性的なアドバイスに関しては、理解しているのですが、感性的な選択に誘惑をされているのです。

最終的には、理性と感性をうまく組み合わせないと、そのAIは使用されなくなる可能性が高いです。日々「お酒を飲むな」とだけ言うAIは、アプリを削除されるでしょう。そのAIは人間の感情や感性的な意思決定を考慮していないからです。

これは、「ただしい知性」と「やさしい知性」についての話と共通しています。AIが現在得意としているのは、「ただしい知性」です。しかし、AI自体がその「ただしさ」を理解しているわけではありません。AIが行っているのは、あくまで最適化です。

最適化とは、特定の目的を達成するために、与えられた制約条件内で最良の解を見つけることです。例えば、営業員がどのように顧客を訪問するかという問題を最適化する場合、その最適化された結果は目的によって変わります。移動距離を最小にする最適化では、最短ルートが示されます。売上を最大にする最適化では、売上見込みが高い顧客から順に訪問するルートが示されるでしょう。AIが何を「正しい」と判断し、どのように行動するかは、人間の目的設定に依存しています。目的設定によっては、「ただしい知性」である場合も、「やさしい知性」として機能する場合もあります。

しかし、現在のAIは多くの場合、「ただしい知性」に偏っています。それはやさしく振舞うためのデータがかけていることが原因です。つまり、感性に関するデータが不足しているからです。

現在のAIは自律的に生きているわけではないので、何らかの外部からの指示が必要です。カメラやマイクが搭載されていれば、限られた範囲での視覚や聴覚的機能を持つことは可能です。画像データや音声データはデジタル信号として扱いやすく、AIとの相性は良いです。さらに、温度センサーや嗅覚センサー、湿度センサー等を装備すれば、多種多様なデータを収集することが可能です。

それでは、私たち人間は、「喜んでいる人」をどのように理解しているでしょうか。究極的には、それは「雰囲気」で判断しているのではないでしょうか。笑顔を見て、楽しそうな声を聞くことで、その人が喜んでいると予測できる場合もあります。しかし、人間は視覚、聴覚、感覚を使って相手の感情を読み取っています。顔は笑顔でも、声が沈んでいれば何か問題があるのかと感じます。しかし、AIであれば、カメラで笑顔を認識し、「この人は喜んでいる」と判断することになるかもしれません。それはカメラの視野内で認識できる表情しか判断材料にならないからです。人間が感じる「雰囲気」は、まだAIには理解できません。

感情認識については、現在のAIは音声や画像データを用いて一定の精度で感情を認識することが可能です。しかし、その精度は、人間が自然に感じ取る感情の複雑さには及びません。感情は多次元であり、その時々の状況や文脈に強く依存しています。AIが未だに到達していない領域の一つです。それでも、感情認識技術は進歩を遂げており、今後さらに高度化する可能性があります。

********************************

人間の知性と機械の知性の大きな違いは、現状では「感性」を理解しているかという点にあります。今の機械学習で用いられいてるデータでは「感情」のデータが圧倒的に不足しています。それでは、感情を理解するためのデータを様々な角度から集めたら(画像や音などを複数のデータを組み合わせて認知するものを「マルチモーダル」と呼びます)、感情の理解が可能になり、「感性的な意思決定」の支援もできるのでしょうか?

現時点ではNOだと思います。その理由を次回執筆します。

更新の通知を受け取りましょう

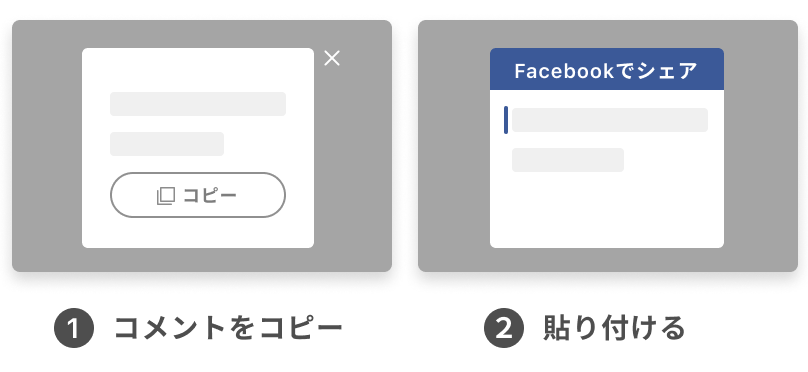

投稿したコメント