「多様な意見」が大切なのは、LLMも人間も同じであるという研究のお話

人間はひとりで生きているわけではなく、社会の中で他人や生物とのつながりの中で生きている。そのつながりを通して知識を獲得している。

ChatGPTのような大規模言語モデル(LLM)が急成長し、人間が作るような文章を生成する能力や推論する能力を示しているが、現在のLLMは、ハルシネーション(Hallucination:幻覚)と呼ばれる事実とは異なる回答や文脈とは関係の無い回答をすることがある。そこで、LLMにより”深い”言語理解をさせるために、人間と同様に集団で推論させるとどうなるか、という実験結果が報告された。浙江大学とシンガポール国⽴⼤学の研究グループによる成果だ。

実験では、LLMを搭載した複数のエージェント(LLMエージェント)がシミュレーションされた「社会」の中で協働する。個々のエージェントの性能を単体で向上させようとするのではなく、協力を通じて創発的な知能を実現できないか、という試みだ。

これまでの研究で提案されているLLMエージェント同士に会話させると、相手のエージェントの言うことに賛同する、という行動がみられることが多い。

たとえば、スタンフォード大学やグーグルの研究者らによって提案された生成エージェントの研究でも、上記のような相手の言う事に賛同するという振る舞いを示す。こうした同調圧力が高くなり過ぎると、集団による問題解決にはつながらないことが課題となる。

そこで、LLMエージェントが効果的に協力できるための仕組みを探るため、研究者たちはお気楽か(easygoing)自信過剰か(overconfident)という性格を持つエージェントで構成される「社会」をシミュレートした。これらのエージェントは、「ディベート(Debate:議論)」か「リフレクション(Reflection:内省・熟考)」するかのいずれかの思考パターンを用いて、協働する。

たとえば、3人のエージェントに対して数学やチェスの問題を与え、上の図のように協働で解かせる。ここで「ディベート・リフレクション・ディベート」といった協力戦略を与える。ディベートでは3人のエージェントに議論させ、お互いの考えをシェアする。その後、リフレクションでは、エージェントがそれぞれ自分の考えを内省する。最後に、ディベートでこれまでの議論と自分の考えをもとにさらに議論して考えをシェアし、多数決で問題に対する解を出す。この例のように3回のラウンドを行う場合、協力戦略は全部で8通り(2^3)のパターンがありうる。

全ての協力戦略を試した結果、ディベートから始めるほうがリフレクションから始めるよりも、正解率が高くなった。また、連続してリフレクションを行うとよりハルシネーションすることも分かっている。特に良い性能を示したのは、ディベート・ディベート・リフレクションの場合であった。

これはリフレクションによってエージェントが自分の意見に自信を持つと、仮にそれが間違っていても自分の意見に固執し続ける傾向があるためだ。そのため、ディベートを最初に取り入れることで、バイアスを和らげることができるのだ。特に、ディベートが2回連続することで、エージェントはまず徹底的にお互いの視点が共有され、内省の前に視点の多様性が十分に得られるのだ。ディベートで交わされた多様な意見をまとめ、自分自身の意見とともに他者の意見を取り入れながら、自分の立場を再評価することにつながる。

一方、ディベートのみを行った場合は、自主的な思考が伴わず、集団思考に陥る危険性も示した。ラウンドの数を増やした場合の実験も行われたが、3回以上増やしても性能が向上するわけではないことも示されている。エージェントに与える性格(お気楽か自信過剰か)が結果に与える影響も少ないという。性格よりもどのような協力戦略を採用するかの方が重要だということだ。個々の特性よりも、集団力学がエージェントの行動を形成するという人間の集団で見られる現象に似ている。

この結果は、これまでの社会科学で得られている知見が、より社会的に知的なLLMエージェントシステムの設計のためにも役立つことを示唆している。

こうした研究が進めば、複雑な問題を解決したり意思決定するときに、エージェントの集団に意見を聞いてみるという未来も近いかもしれない。また、ゲームに応用すれば、よりリアルな協働作業や集団行動をするキャラクターをデザインでき、人間が与える戦略によってキャラクターの行動を柔軟に変えられる。「信長の野望」のような戦略が重要なゲームに応用されれば、ユーザは単なるシミュレーションを超えた体験につながりそうだ。

更新の通知を受け取りましょう

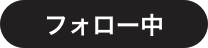

投稿したコメント