ガザではAIが人を殺している

筆者は「ITと人権」という看板を掲げています。巨大IT企業(ビックテック)の将来を考えるには、そして情報技術(IT)と社会との摩擦について考えるには、人権(human rights)という「思考の枠組み」が欠かせない——という問題意識があるからです。

今回の記事では、イスラエル軍によるガザ攻撃に使われているAI(人工知能)の話を取り上げます。

イスラエルのメディア『+972 Magazine』の2023年11月30日付けの記事は、イスラエル軍はガザの空爆のため、Habsora(福音)と呼ぶAIシステムを使っていると報じました。人間のスタッフよりはるかに高速に、空爆の爆撃目標を「生成」するAIです。ガザ攻撃が始まってから、イスラエル軍は35日間で1万5000の目標を攻撃しましたが、こうした大量の目標の情報を「生成」するために、AIシステムが使われたというのです。

しかも、このAIは非常に残酷な仕事をします。『+972 Magazine』の記事は、民間人の住居が攻撃目標となり、しかも巻き添えで無関係な死者が出ることをイスラエル軍が許容していることを暴いています。ガザ空爆では、民間人が多数犠牲になっていることが報じられていますが、それは意図的なものでした。攻撃目標のカテゴリーの中に「民家」というカテゴリーがあるのです。一般市民が暮らす民家であっても、「ハマス工作員が出入りしている」といった情報に基づき攻撃目標にしてしまう。それも、巻き添えにより無関係な死者が出ることを認識しながら、です。そして、この「民家」を攻撃し民間人の死傷者を多数出した責任の一端は、AIシステム——実質的にはこのAIを開発し訓練した開発者たち——にもある訳です。

多くの読者は、IT(情報技術)で人が死ぬことについて、あまり意識したことはなかったと思います。しかし、このようなAIの軍事利用や、自動運転車の登場により、AIの誤動作で、あるいはAIの意図的な指令により人が死傷する出来事が発生しています。AIや、その他のITの責任は大きくなり、開発企業の経営者や開発者にも厳格な倫理規範が求められる時代になったといえます。

こうした倫理規範——やっていいこと、いけないことの原則——の基礎にあたるものが人権です。軍事用の人を攻撃するAIは論外としても、民間企業が作るAIが人権侵害をする事例がいくつも出ています。こうした動向には気を配りたい、というのが筆者の立場です。

(写真:GettyImages)

更新の通知を受け取りましょう

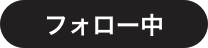

投稿したコメント