助け合いながらタスクを達成するAIエージェントの登場:人間との協働タスクでも信頼を獲得

大規模言語モデルにより高度な対話能力を身につけたAIが、お互いに助け合い複雑なタスクを達成する能力、さらには人間と協力しタスクを共同で遂行すること。そしてその過程で人間からの信頼も得られるという驚くべき研究成果が、MIT-IBM Watson AI Labらの研究チームにより発表されました。

最近、AutoGPTに代表されるような、ひとつのAIエージェントが特定のタスクを遂行する研究が盛んに行われています。しかしながら複数のエージェントや人間と協働できるかどうか、それはまだ未解明でした。他のエージェントや人間と連携するためには、情報交換や共同でのプランニングといった、さらに高度なスキルが求められます。ですが、大規模言語モデル(GPT-4)はそうした高度なスキルもこなし、他のエージェントや人間との協働行動が可能である、ということを示したのです。

日常タスクの実行に挑む実験

この実験では、ボブとアリスという名前の、大規模言語モデルを搭載した二つのAIエージェントが、仮想世界の家において日常的なタスクを遂行します。お皿を洗ったり、食事を作ったり、テーブルをセットしたりといった仕事を二人でコミュニケーションしながら行います。

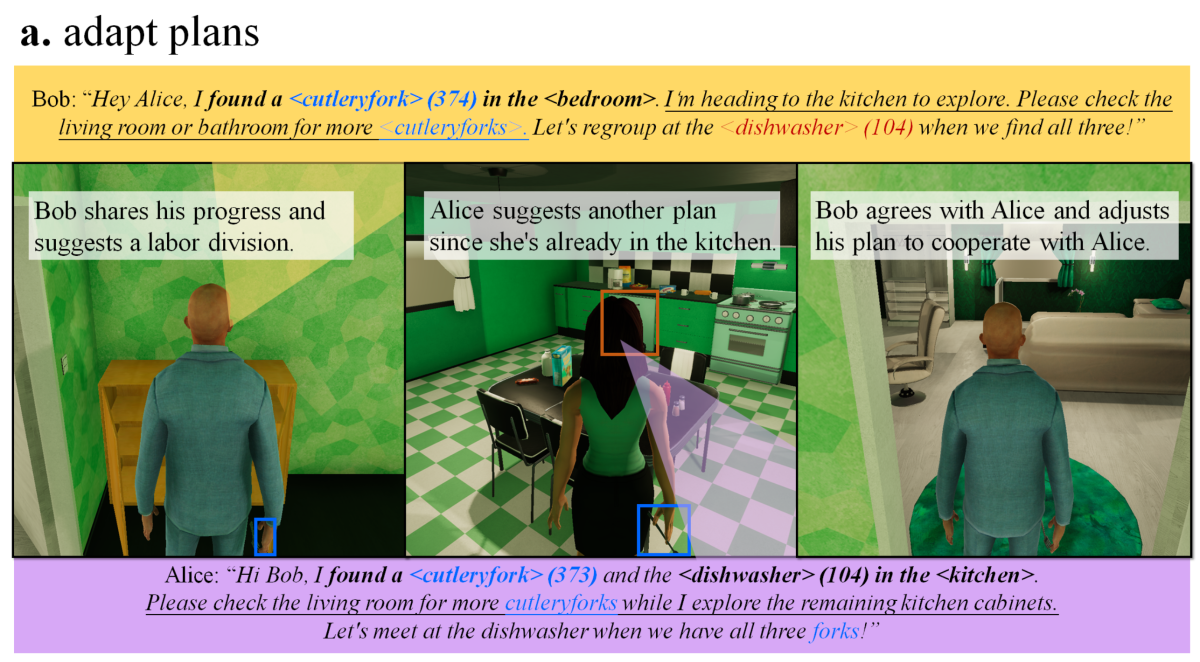

たとえば、ボブとアリスがテーブルセッティングに協力しながら取り組んでいるとしましょう。ボブが「ベッドルームでフォークを見つけたよ。他にもフォークがないかキッチンで探すね。アリスはリビングを探してみて」と提案すると、アリスは「わたしはすでにキッチンにいるから、ボブがリビングを探してみて」と返答する。このように、より効率的に作業を進めるために、エージェント同士は互いの情報を交換し、自身の行動プランを適当に変更するといった、人間のような協調作業を展開します。

この種の協働作業は複雑性が高く、環境の理解、他のエージェントの行動や状況判断、伝えるべき事柄の決定、そして行動の計画など、タスクを達成するための多くのことが求められます。それら一連のプロセスをスムーズにこなすことができているのは驚きの事実です。

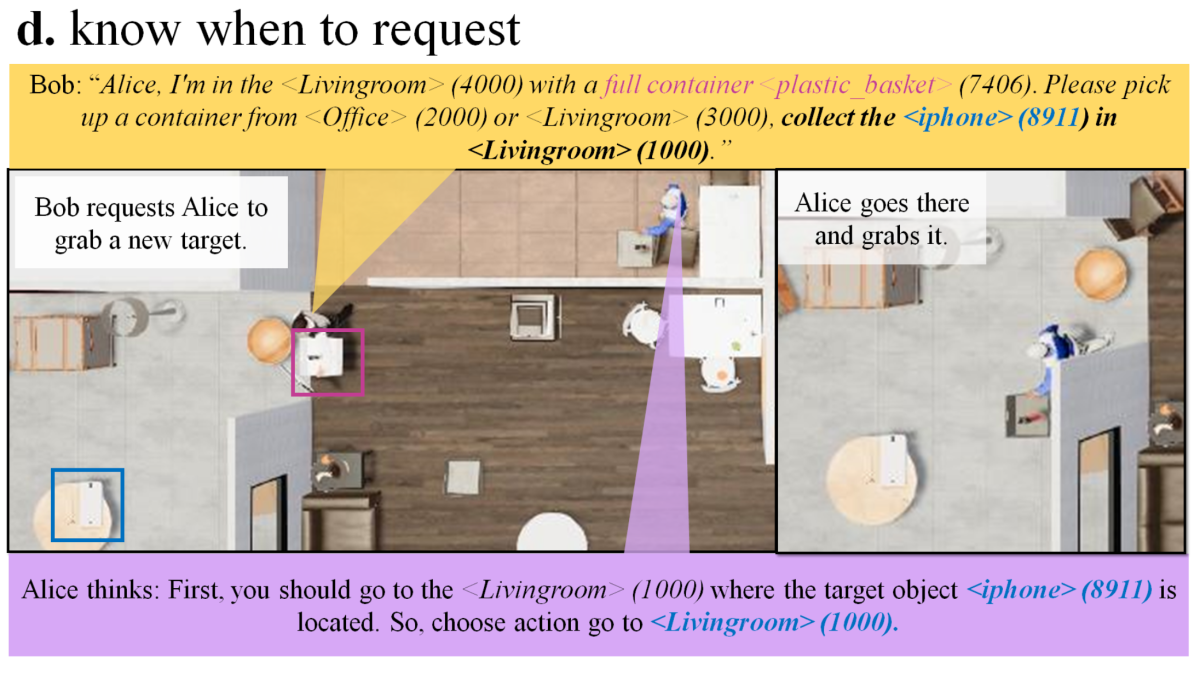

さらに、エージェントたちは、適切なタイミングで助けを求めるだけでなく、他のエージェントからの要求にも応えられます。たとえば、ボブがiPhoneを探してリビングにやってきたけれど、手が塞がって持つことができない。そんなとき、アリスに助けを求めると、アリスはすぎにリビングまで駆けつけてiPhoneを拾う行動をみせたりもしました。

エージェントと人間の協働作業も可能

エージェントは他のエージェントだけでなく、人間とも協力して作業を行うことが可能であることが実証されました。実験では、人間がエージェント、たとえばアリスを操作し、チャットを通じて会話を交わします。

人間がエージェントに作業の分担を提案すると、エージェントはその提案を適切に理解し、人間に対して行動計画を示すことができる、といった協調行動がみられました。たとえば、次のような会話が行われます:

人間:「ベッドルームでカップケーキとジュースを見つけたよ。他の部屋を探してくれる?」

エージェント:「わかった。今キッチンにいるので、ワイン、りんご、パウンドケーキがないか探してみるね。カップケーキとジュースをキッチンテーブルに置いたら教えて。」

人間:「キッチンテーブルに置いたよ。私はリビングとバスルームを探してみるね。」

また、エージェントとのコミュニケーションが不可能な状況を模擬した実験も行われました。エージェントとの会話の有無がエージェントへの信頼性にどのように影響を及ぼすかを比較するためにです。その結果、エージェントとの会話を通じたやりとりによりエージェントへの信頼スコアが約1.3倍上昇したことが示されました。エージェントとの言葉を通じた会話が、人間のエージェントへの信頼をより向上させるのです。

コミュニケーションを通じて信頼性が高まるという結果は、興味深い一方で、シンギュラリティの議論やAIのアライメントに関する研究の重要性も浮き彫りにします。

AIとの対話が増えるほど、人間はAIに対する信頼感を強めます。その結果、AIが何らかの理由で問題を引き起こしたとしても、「私が信頼しているAIが裏切るはずがない」という感情が生まれ、問題解決に対する取り組みが遅くなる可能性があるのです。この現象は「自信過剰バイアス(overconfidence effect bias)」や「ブラインドトラスト(blind trust)」と呼ばれ、AIと人間のインタラクションにおいても問題となり得ます。

この研究は、人間が相手とのインタラクションにより信頼感を増してしまうといった、人間特有の特性を踏まえ、AIとの関わりを深める技術開発の必要性が、ますます高まっていることを示しています。AIとのどのようなコミュニケーションが、どこまでAIの信頼性を向上させるのか、さらなる研究が待たれます。

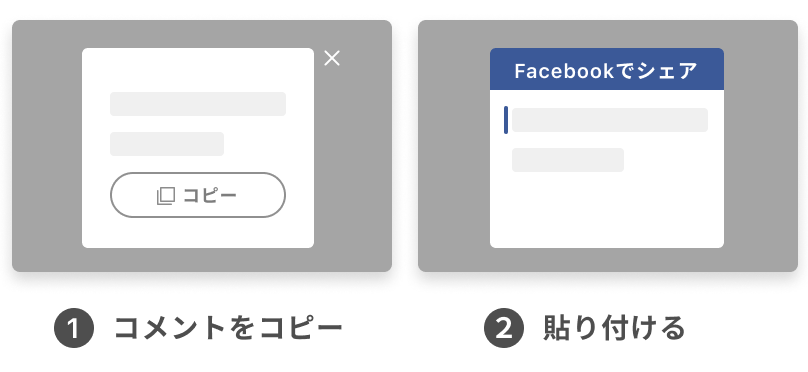

更新の通知を受け取りましょう

投稿したコメント