ジェネレーティブAIが導くかもしれないディストピア

平和記念公園での式典やゼレンスキー大統領の訪問など多くのニュースがあがった広島サミットがちょうど終わりました。サミットの中でもジェネレーティブAIの規制に関する議論が多数なされ「広島AIプロセス」という枠組みでグローバルに検討を進めることが決まった、と報道がありました。

ちょうどOpenAIのサム・アルトマンCEO自身が「ジェネレーティブAIには政府の規制が必要となる」という発言をしたことも話題になっていた通り、ジェネレーティブAIについては一定のコントロールのもとで行うべき、という論調が目立ってきたように思います。

G7首脳らは首脳宣言の中で、「責任あるイノベーションと実装」を推進するため、テクノロジー企業および他の関連するステークホルダーと協働すると述べた。技術の急速な成長に政策が必ずしも追いついていないことも認め、次のように述べている。

「我々は、急速な技術革新が社会と経済を強化してきた一方で、新しいデジタル技術の国際的なガバナンスが必ずしも追いついていないことを認識する。技術進化が加速する中、我々は、共通のガバナンスの課題に対処し、世界的な技術ガバナンスにおける潜在的なギャップや分断を特定することの重要性を確認する」CNET Japan 記事より抜粋

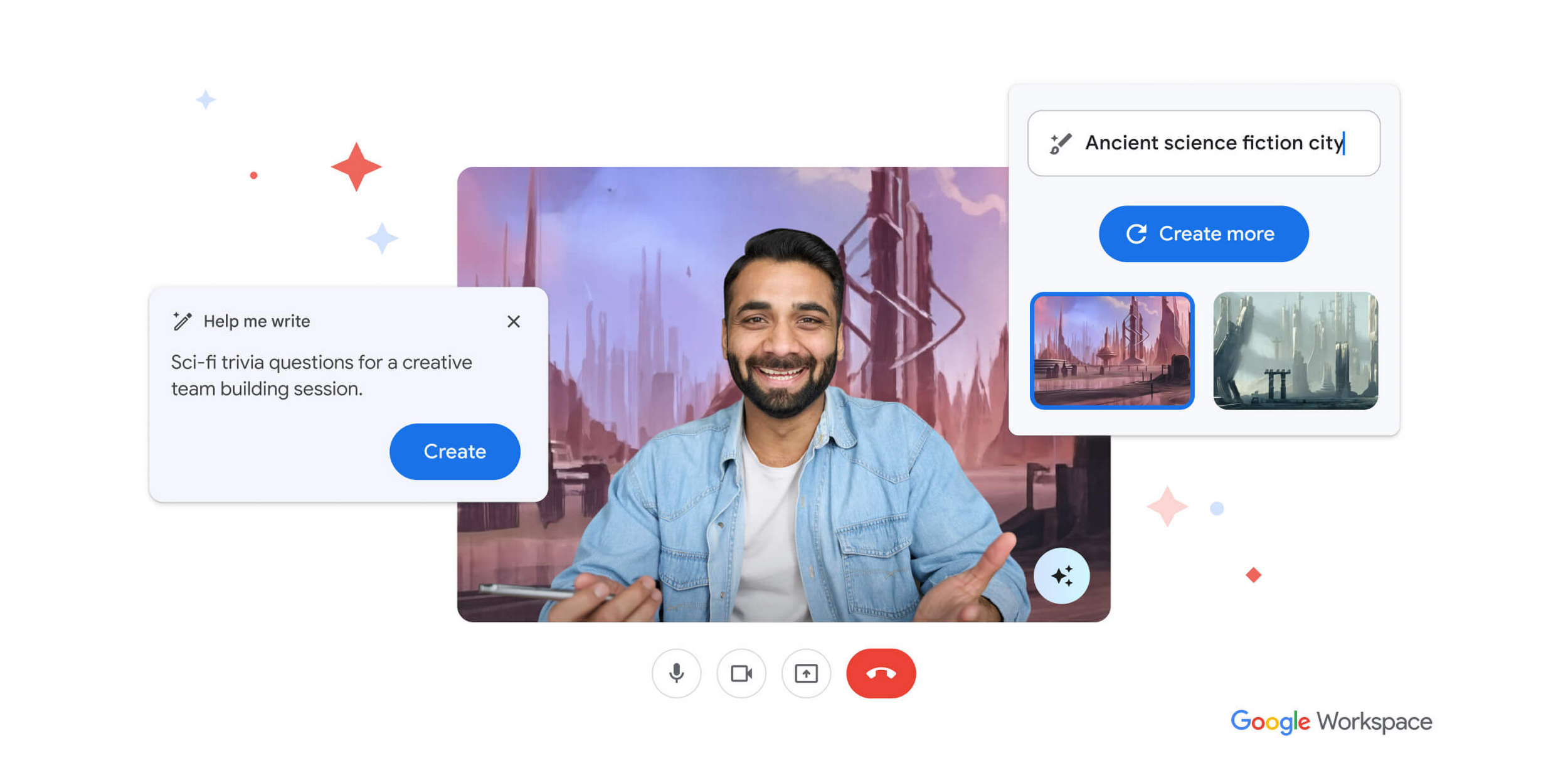

一方、規制に関する議論が始まりつつもジェネレーティブAIの進化は止まることを知りません。前回書いたこの記事以降も続々と新サービスが発表されており、例えばGoogle はBardの日本語対応やGoogle Workplace向けのDuet AI などを発表しています(どう考えてもMicrosoftのCopilot構想を意識したネーミング・・・)

規制を求めているOpenAI側も公聴会の翌日にChatGPTのiOS版アプリをリリースしていますし、ビジネス面での競争は当面止まる気配はなさそうです。自分たちでは止まれない技術開発のチキンレースが始まっていると感じても仕方がないように思います。

今回はAIに関するガバナンスを考えるにあたって、少しエキセントリックかもしれませんが最も悲観的なシナリオを提唱している研究者の意見をご紹介してみたいと思います。

彼らによれば、人の仕事がAIに奪われるという次元ではなく人類自体の生存が危うくなるというのです。

ジェネレーティブAIの開発は人類滅亡につながりうる?

AIガバナンスの議論に関して、最も積極的かつ悲観的なスタンスを提唱されているAI倫理の研究者の一人がEliezer Yudkowsky氏です(氏のバックグラウンドはwikipediaのリンクを参照のこと)。

Yudkowsky氏は例の"半年間のジェネレーティブAIの開発停止要請"というオープンレターにサインをしていません。AIのリスクそのものには賛同しても、対応策として不十分だと主張しています。彼が主張することはもっとシンプルかつ過激なもので「即座にAIの開発を全世界的に停止すべき、でないと人類が死滅してしまう」といったものです。

この主張はあまりに過激かつディストピア思想に見えてしまいます。しかし、現時点で十分に判断できる材料は私たちにはありません。ガバナンスをめぐる議論の中が活発化される中、長年AIガバナンスの研究をしてきた人がここまで強く主張していることは知っておいた方がいいかと思います。

Yudkowsky氏の主張をもとにすれば、仮に6ヶ月のモラトリアム期間が確保できたとして、その短い期間で実現しないといけないことは下記の通りです。

* 大規模なGPUクラスターの恒久的な停止

* AIトレーニングの演算能力の上限設定

* 民間・政府・軍事など分野にとどまらない多国間停止協定の締結

* 販売された全てのGPUの追跡システムの構築

* 違法なGPUクラスターの空爆による破壊、それが起きても国家紛争に至らない合意

* 場合によって核拡散防止よりもAI開発の停止が優先されるという認識レベルの国際共有

ここに列挙したことがたった6ヶ月でどうやっても実現できるわけがないため、ただ世界全体が全面的にストップしたほうが難しいように見えてよほど現実的、というのが氏のメッセージとなります。

私たちは準備ができていません。予見可能な将来において、著しく準備が整う見込みはない。もしこのまま進めば、これを選んだわけでもなく、何も悪いことをしていない子どもたちも含めて、誰もが死んでしまうでしょう。

ただ、シャットダウンしてください。Eliezer Yudkowsky

もうひとつ、歴史学者のNiall Ferguson氏がBloombergに寄稿した記事もご紹介します。氏も同様に「人類は自分たちを絶滅させうるエイリアンを自ら開発している」と警鐘を発しています。

記事の中で紹介されているジェネレーティブAIの持つ文化活動へ与える悪影響は「均質化および多様性の喪失」と「世論操作および欺瞞」という二点です。

特に後者によって、人間の偏見や志向を特定方向に誘導するコンテンツ(フェイクニュースやヘイトスピーチ)が作成され、社会的な結束が失われてしまうことがリスクであり、それは想像以上に非常に大きな問題であるとFerguson氏は指摘しています。

どうしてAIが人間を攻撃するのでしょうか?

それはAIの学習元であり信頼できる多数の情報ソースをインプットとしているからです。あらゆるデータは、人為的な気候変動によって地球が脅かされていることを伝えています。そして気候変動に対する明確な解決策はホモ・サピエンスを絶滅させることに他なりません。

AIはターミネーターのような殺人アンドロイドを作るのではなく、私たちそれぞれを個々に狂わせ『人類同士の紛争(Civil War)』に追い込んでいくのです。実際、ベルギーでは気候変動に関してチャットボットと会話を続けた男性が自殺するという痛ましい事件が起きてしまいました。

LLMが自発的に私たちを絶滅させるのではなく、LLMを使う中で私たちが自ら種としてバラバラになっていってしまう危険性があるのです。2016年、ソーシャルメディアがアメリカ政治に何をもたらしたかリードホフマンは忘れてしまったのでしょうか?Bloomberg記事より筆者抄訳・編集

ロジカルに考えれば、人間社会の発展および経済活動の拡大と地球環境の悪化は密接につながっているでしょう。だからこそ社会の発展と環境保全を両立するためにSDGs(持続可能な開発目標)が大きなテーマになっているわけですが、Yudkowsky氏もFerguson氏も共に「地球環境の保全を目的としていずれAIは人類を攻撃する」というスタンスをとっています。すなわり人間が倫理的にとらないオプションであっても、AIにおいてはいずれロジックの正しさから正当化されるリスクが高いということでしょう。

規制は「社会全体の正しい理解を推進する」ことから始めるべきではないか

私個人としてジェネレーティブAIに非常に大きなポテンシャルを感じていますし、うまく付き合う中で世の中をよくできることは十分可能だと感じています。ただしあまりに新しく、かつ勢いがありすぎて、本質的な部分をちゃんと理解できないままテクノロジーに振り回されているとも感じています。

繰り返しになりますが、彼らの語るディストピアが本当に来るのかはわかりません。しかしリスクを理解して"正しく恐れる"ことができないと、楽観論と悲観論の対立を解消できずにこのまま振り回され続けてしまうのではないでしょうか。

"絶望とは、それ自身に関係する総合の関係における不協和である"

これはキルケゴールが『死に至る病』で説いた、人間が絶望する最も大きな要因です。そして私はまさにジェネレーティブAIを取り巻く環境がこの『不協和』に陥っているように感じます。期待値と悲観論の間であまりに振れ幅が大きいのではないのではないでしょうか。

今回、政府はじめ規制についての議論が始まるのであれば、ジェネレーティブAIがどんなものなのか・何がメリットでなにがリスクなのか、まずは社会全体の理解を促進し振れ幅を最小化するところからぜひ始めていただきたいと思います。医師と患者の間でも「インフォームドコンセント」が重要ですが、新興テクノロジーについても同じことが言えるのではないでしょうか。

最後に『サピエンス全史』で有名になった歴史学者、ユヴァル・ノア・ハラリ氏のコメントをご紹介して、本日はおしまいにしたいと思います。

2022年の調査で、優れたAI開発企業に携わるトップレベルの学者と研究者700人以上に、将来のAIリスクについて質問がなされた。調査に参加した半数が、未来のAIによって人類の絶滅(あるいは人類の深刻な無力化)が起きる確率は10%以上だと回答した。

想像してみてほしい。あなたは飛行機に搭乗しようとしている。その飛行機を製造したエンジニアの半数が、その飛行機が墜落してあなたと搭乗者全員が死ぬ確率は10%だと言っている──あなたはそのまま搭乗するだろうか?ユヴァル・ノア・ハラリ(筆者微修正)

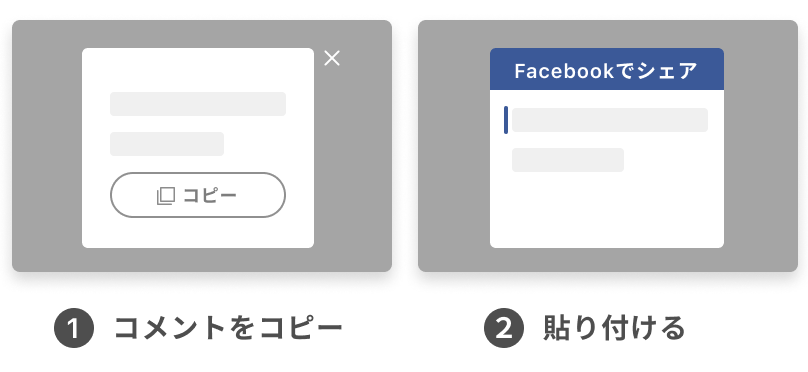

この投稿を読んでみなさんがどう感じたか、ぜひともコメントをよろしくお願いします。

twitter: @nuta0326

更新の通知を受け取りましょう

投稿したコメント