“GPUのNVIDIA”がCPU製品「Grace」を投入、スパコンのAI性能が10倍に

コメント

選択しているユーザー

話題の GPT-3 は 1750 億パラメーターなので FP32 とすると必要なメモリー容量は 700GB

これに対し GPU のメモリー容量は A100 でも 80GB なので nvlink でマルチ GPU にしても大半がパラメーターで占められてしまう

さらに GPT-3 の訓練データは 45TB と言われているのでメインメモリーとの通信がボトルネックなっている事は十分あり得る

Grace によって CPU と GPU とメインメモリーが全て nvlink で通信可能になった事が性能向上の主要因だろう

2023年に稼働すると言うスイス国立コンピューティングセンターのスーパーコンピュータ「ALPS」の AI 処理性能は 20エクサFLOPS で富岳の 10 倍

日本はポスト富岳のロードマップを引いた方が良い

注目のコメント

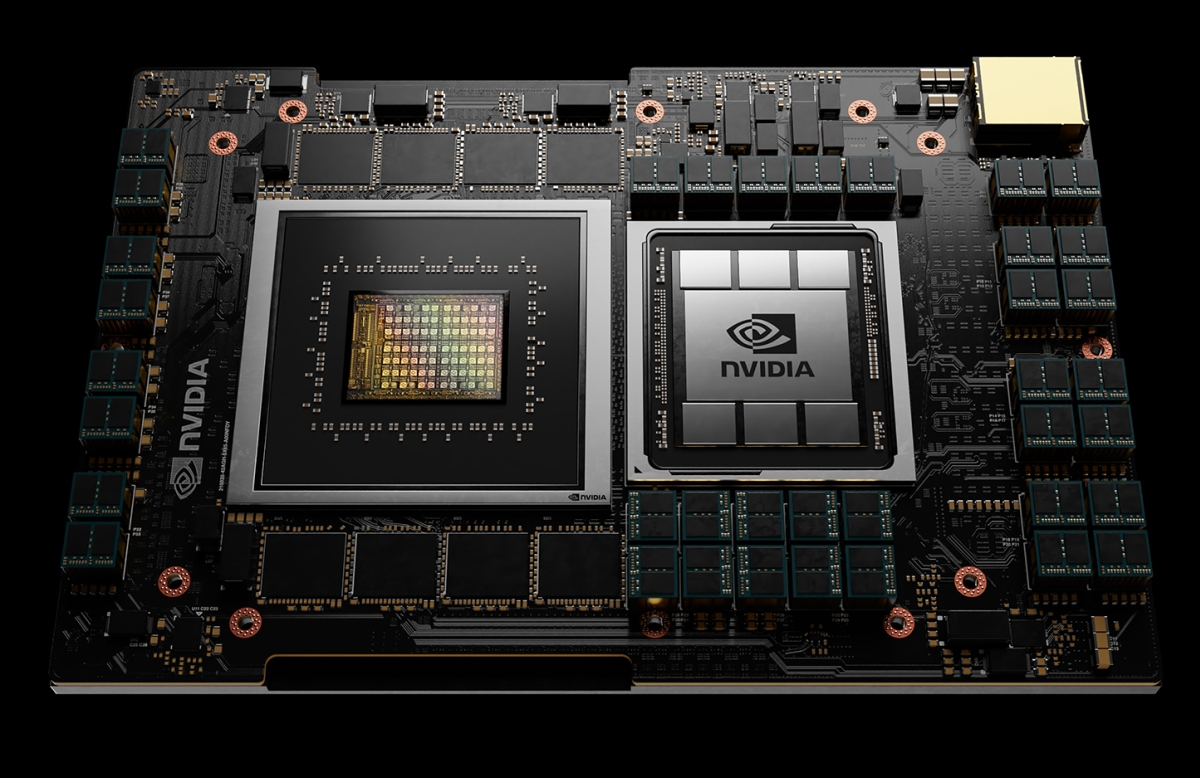

Nvidiaが発表したCPUのGraceについて、発表の資料のスクショ含めて端的な違いが分かりやすい。Grace同士がつながり、また他のGrace・メモリ・GPUとのつなぎ方が双方向になっていて、かつそこをNVLinkという規格で帯域を広げている。それによってメモリがボトルネックとならないようにしていて、それを求めるアプリケーションで効くということ。

想定しているのが機械学習用途でのサーバーで、学習モデルがどんどん複雑になっているから。下記もNvidiaの発表についての記事だが定量的には下記のような状況を踏まえて、それに適応したアーキテクチャを提供することで追い風としたいのだろう。CPU単体としてとらえるのではなく、機械学習用システムアーキテクチャーとして捉える方が正しい気がしている(NVLinkなど含め)。

『同社によれば、機械学習モデルの規模は拡大傾向にあり、特にNLPモデルではパラメーター数は2.5カ月ごとに2倍と指数関数的に増加しているという。例えばNLPモデルの1つである「GPT-3」の場合、既にパラメーター数は1000億を超えているとする。このペースで増加すれば、23年ごろまでに機械学習のパラメーター数は100兆に達するとみている。このような巨大なモデルを現在のコンピューターアーキテクチャーで学習させるとCPUやGPU、システムメモリーなどを接続するインターコネクトの速度がボトルネックになると指摘した。』

https://newspicks.com/news/5819969